KI-konforme Validierungsprozesse

Sicherstellung von Compliance und Effizienz

Einleitung

Die zunehmende Integration von Künstlicher Intelligenz (KI) in Geschäftsprozesse eröffnet Finanzdienstleistern erhebliche Chancen und Potenziale, stellt sie aber zugleich vor neue Herausforderungen. Spätestens mit dem Diskussionspapier der EBA zum Einsatz von Machine Learning für IRB-Modelle in der Modellvalidierung ist klar, dass auch die Aufsichtsbehörden den Einsatz von KI in der Risikomodellierung immer mehr in Betracht ziehen. Während der produktive Einsatz von KI-Modellen noch mit Zurückhaltung betrachtet wird, empfiehlt die EBA ausdrücklich den Einsatz von KI als Challenger-Modell in der Validierung.

Traditionelle Validierungsansätze sind auf klassische statistische Modelle ausgelegt und berücksichtigen den Einsatz von KI bislang nur begrenzt. Um den wachsenden regulatorischen und technologischen Trend gerecht zu werden, empfehlen wir, Validierungsstrategien gezielt einzusetzen, um klassische Modelle effizienter und umfangreicher zu bewerten und zu kontrollieren.

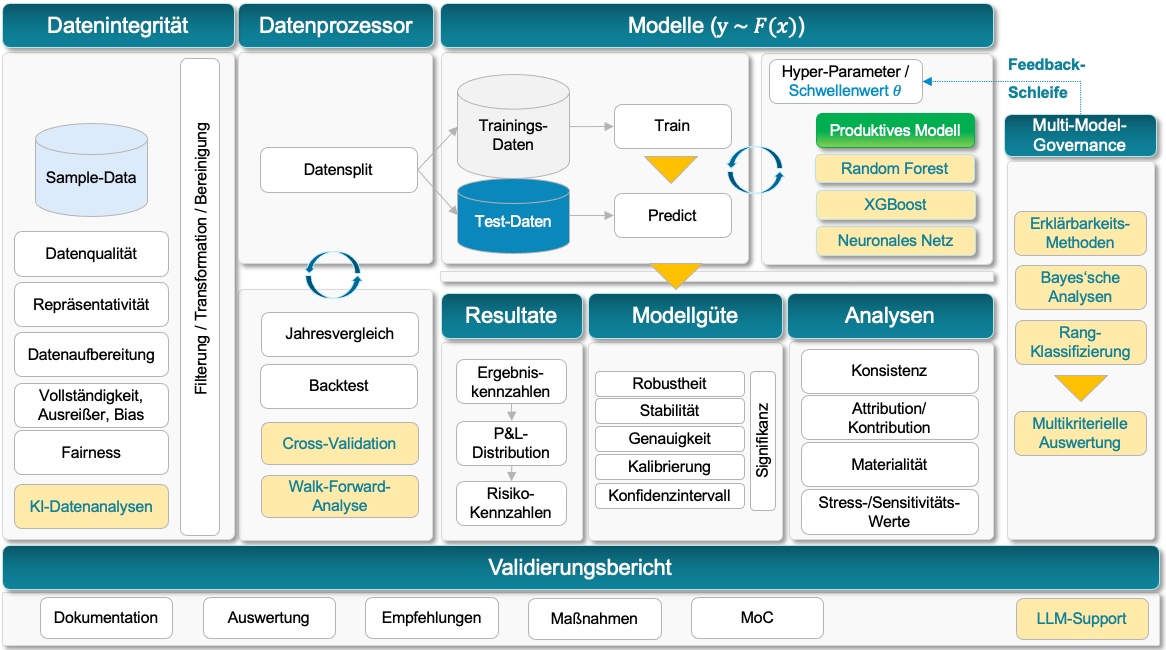

In diesem Artikel erläutern wir, wie ein erweiterter Validierungsprozess mit KI-Modellen gestaltet werden kann, welche Best Practices aus klassischen Methoden übernommen werden sollten und welche neuen Ansätze erforderlich sind, um den spezifischen Herausforderungen von KI-Modellen gerecht zu werden. Dabei stehen insbesondere die zentralen Elemente des Validierungsprozesses im Fokus.

Ein gut strukturierter KI-Validierungsprozess ermöglicht es Unternehmen, KI-Modelle effizient, transparent und regelkonform einzusetzen, während gleichzeitig Modell-Risiken minimiert und regulatorische Anforderungen erfüllt werden.

Erweiterter Validierungsprozess für KI-Modelle

Schritte im Validierungsprozess

Dieser Schritt dient der Sicherstellung, dass die Daten für sowohl das produktive als auch das Challenger-Modell konsistent und unverzerrt sind. Neben klassischen Methoden ermöglichen moderne KI-Ansätze ein initiales Scannen und kontinuierliches Monitoring der Daten. Automatisierte ‚Ongoing Monitoring Features‘ zur Überwachung der Einhaltung von Annahmen werden zunehmend eingesetzt, auch ohne KI. Dennoch bieten moderne Machine-Learning-Methoden erweiterte Möglichkeiten, besonders bei großen Datenmengen, komplexen Datenflüssen und verschachtelten Systemlandschaften.

Ansätze zum Monitoring:

- Drift Monitoring: Überwachung von Veränderungen in Eingangsdaten und deren Beziehung zur Zielvariablen. Es werden hauptsächlich zwei Arten unterschieden:

- Feature Drift: Veränderung der Verteilung von Eingangsmerkmalen (Features) über die Zeit, z. B. Änderungen in der Einkommensverteilung von Kreditnehmern.

- Concept Drift: Veränderung der Beziehung zwischen Eingabedaten und Zielvariable, etwa wenn gestiegene Zinsen zu höheren Ausfallwahrscheinlichkeiten führen, selbst bei einkommensstarken Kreditnehmern.

- Statistische Methoden: Bewährte Verfahren zur Identifizierung von Unterschieden zwischen Datensätzen und Verteilungen, wie:

- Kolmogorov-Smirnov-Test: Prüft, ob zwei Wahrscheinlichkeitsverteilungen signifikant unterschiedlich sind.

- Jensen-Shannon-Divergenz: Misst die Ähnlichkeit zwischen zwei Wahrscheinlichkeitsverteilungen.

- Wasserstein-Distanz: Bestimmt den minimalen Aufwand, um eine Wahrscheinlichkeitsverteilung in eine andere zu transformieren.

- Vergleich mit Referenzdaten: Kontinuierlicher Vergleich von neuen Daten mit den ursprünglichen Trainingsdaten.

- Alarme für Threshold-Überschreitungen: Automatische Benachrichtigungen bei signifikanten Veränderungen.

Traditionelle Validierungsmethoden wie Backtesting und Jahresvergleiche werden häufig genutzt. Für KI-gestützte Modelle sind diese jedoch oft unzureichend, da solche Modelle in der Regel mehr Daten und spezifische Validierungstechniken erfordern. Eine bewährte Methode ist die Kreuzvalidierung (Cross-Validation), die eine robuste Bewertung der Modellperformance ermöglicht, indem sie das verfügbare Datenmaterial effizient nutzt.

Kreuzvalidierung

Die Kreuzvalidierung ist eine essenzielle Technik im maschinellen Lernen, um die Generalisierungsfähigkeit eines Modells zu bewerten. Im Vergleich zu klassischen Backtesting-Ansätzen nutzt sie die vorhandenen Daten effizienter. Während Backtesting typischerweise nur einen einzigen Trainings-Test-Datensatz verwendet, ermöglicht die Kreuzvalidierung eine robustere und umfassendere Bewertung.

Beispiele:

- K-Fold-Cross-Validation: Die Daten werden in K gleich große Abschnitte (Folds) unterteilt. Das Modell wird also K-mal trainiert, wobei jedes Mal ein anderer Fold als Testdatensatz dient, während die restlichen Folds für das Training genutzt werden.

- Leave-One-Out-Cross-Validation (LOOCV): Jeder einzelne Datenpunkt dient einmal als Testdatensatz, während alle anderen Datenpunkte zum Training verwendet werden. Dieser Ansatz ist besonders bei kleinen Datensätzen nützlich.

- Stratified Cross-Validation: Ähnlich wie K-Fold, jedoch wird hier die Verteilung der Zielvariable in jedem Fold berücksichtigt, um sicherzustellen, dass alle Klassen proportional vertreten sind. Beispielsweise wird sichergestellt, dass jeder Fold hinreichend viele Kreditausfälle enthält und verhindert, dass ein Fold im Extremfall z.B. gar keine Kreditausfälle enthält.

- Time-Series Cross-Validation: Für zeitabhängige Daten wird die Kreuzvalidierung so angepasst, dass zukünftige Werte nie zur Vorhersage der Vergangenheit verwendet werden, was realitätsnähere Ergebnisse liefert. In diesem Zusammenhang ist insbesondere die Walk-Forward-Analyse zu nennen. Diese ist eine Validierungsmethode, die speziell für zeitabhängige Daten (z. B. Finanzmärkte, Kredithistorien) entwickelt wurde. Sie wird häufig in der algorithmischen Modellierung und im Risikomanagement eingesetzt, um die zeitliche Stabilität eines Modells zu bewerten.

Zusätzlich zum produktiven Modell werden KI-basierte Challenger-Modelle entwickelt, um deren Leistung und Robustheit zu vergleichen. Dies ermöglicht eine kontinuierliche Verbesserung und stellt sicher, dass das optimale Modell im produktiven Einsatz bleibt.

Im obigen Diagramm stehen neben dem produktiven Modell mehrere KI-Challenger-Modelle. Diese Modelle verwenden denselben Dateninput, um eine konsistente Vergleichsgrundlage sicherzustellen. Die KI-Challenger-Modelle werden basierend auf modernen Algorithmen (z. B. Neuronale Netze, Gradient Boosting Decision Trees, Random-Forest etc.) trainiert, wobei die gleiche Datenbasis es ermöglicht, Unterschiede in der Modellarchitektur und -leistung objektiv zu bewerten. Auch der Einsatz klassischer Challenger-Modelle, wie Monte-Carlo-Simulation und Finite-Differenzen-Methoden können hier Teil des Modell-Portfolios sein.

Der Einsatz von Challenger-Modellen hat nicht den Austausch des produktiven Modells als Ziel. Challenger-Modelle dienen vor allem als Werkzeuge zur Validierung und Benchmarking, um Schwächen des produktiven Modells zu identifizieren und als Vergleichsmaßstab für mögliche Optimierungen zu fungieren.

Die Herausforderung besteht darin, die dadurch erzeugte Menge multikriterieller Resultate in geeigneter Form auszuwerten und daraus begründete Empfehlungen und Entscheidungen abzuleiten. Hierfür sollte eine Multi-Model-Governance konzeptioniert und integriert werden, mit der wir uns im nächsten Abschnitt beschäftigen.

4) Multi-Model-Governance:

Richtlinie für die multikriterielle Auswertung des Modell-Portfolios

Zurück zum Diagramm

Der Vergleich zwischen dem produktiven Modell und einem oder mehreren KI-Challenger-Modellen stellt aufgrund der Vielzahl an Ergebnissen (k Algorithmen und n Datensätze), darunter auch ambivalente Resultate, eine strukturelle und entscheidungstheoretische Herausforderung dar.

Die Verwaltung mehrerer Modelle erfordert klare Richtlinien und Prozesse, um Konsistenz und Compliance sicherzustellen. Ein effektives Multi-Model-Governance-Framework hilft dabei, Verantwortlichkeiten zu definieren und den Lebenszyklus der Modelle zu steuern.

Feedback-Schleifen zur Weiterentwicklung des produktiven Modells

Die Multi-Model-Governance legt auch fest, welche Ergebnissetypen berücksichtigt werden, wie sie zusammengeführt, ausgewertet werden aber auch wie darauf basierende Empfehlungen und Maßnahmen abgeleitet werden können, um das produktive Modell kontinuierlich zu verbessern. Dies geschieht insbesondere durch die Integration der Erkenntnisse aus den Challenger-Modellen in Form von Feedback-Schleifen, die eine zentrale Rolle im Validierungsprozess spielen.

Erhebung und Analyse von Ergebnissen:

Die Performance-, Stabilitäts- und Drift-Analysen werden sowohl für das produktive Modell als auch die Challenger-Modelle systematisch durchgeführt, dokumentiert und bewertet.

Erkenntnisgewinnung:

Es wird analysiert, welche Bereiche des produktiven Modells (z. B. spezifische Datensegmente, Szenarien) verbessert werden können. Beispielsweise decken Features, die im Challenger-Modell besser genutzt oder modelliert werden, Modellschwächen auf.

Modellanpassung:

Erkenntnisse aus den Challenger-Analysen fließen in die Parametrisierung des produktiven Modells ein. Dazu gehören:

-

- Feinjustierung von Schwellenwerten oder Risikoaufschlägen.

- Verbesserung der Modellstruktur (z. B. Anpassung von Kategorien, Einbindung neuer Faktoren).

- Einbindung von Ergebnissen der Challenger-Modelle als zusätzliche Inputfaktoren.

Reevaluierung:

Es wird validiert, ob die vorgenommenen Anpassungen die gewünschten Verbesserungen erzielen. Der fortlaufende Vergleich mit den Challenger-Modellen stellt sicher, dass die Änderungen effektiv sind und neue Erkenntnisse berücksichtigt werden.

Über die Feedback-Schleife hinaus sollte die Multi-Model-Governance auch die folgenden drei Aspekte berücksichtigen, die schlussendlich zu der Multikriteriellen Auswertung führen:

Erklärbarkeitsmethoden

Zur Steigerung der Transparenz und Vergleichbarkeit der Modelle werden modell-unabhängige Analysen eingesetzt, wie:

-

- SHAP (Shapley Additive Explanations) und LIME (Local Interpretable Model-agnostic Explanations): Zur detaillierten Analyse des Beitrags einzelner Features.

- Scatterplots und P&L-Vergleiche: Zur Visualisierung der Performance.

- Fehler- und Verlustbilanzen: Um Unterschiede auf Ereignisebene hervorzuheben.

Diese Methoden schaffen eine gemeinsame Grundlage zur Bewertung und Transparenz, indem sie die Modelle sowohl global als auch lokal interpretierbar machen.

Bayes’sche Analysen

Die ROPE-Analyse (Region of Practical Equivalence) ermöglicht den paarweisen Vergleich von Modellen anhand relevanter Unterschiede in Modellgütemetriken (z. B. auf Basis der Kennzahlen AUC, Brier-Score etc.). Differenzen unterhalb eines Schwellenwertes (z. B. 0,01) gelten als nicht relevant. Relevante Differenzen werden je nach Tendenz einem Modell zugeordnet, um die Dominanz eines Modells aufzuzeigen, wenn diese Unterschiede etwa in einem hohen Anteil der Fälle (z. B. 95%) vorliegen. Diese Analyse zeigt, ob zwei Modelle praktisch gleichwertig sind. Der Vergleich trifft keine Signifikanz-Aussage.

Rangklassifizierungen

Signifikante Unterschiede zwischen zwei Modellen (im Sinne eines p-Tests) lassen sich mit Hilfe der folgenden Ansätze untersuchen.

Friedman-Test und Nemenyi-Test:

Wir betrachten die k Modelle auf n Datensätzen. Mit dem Friedman-Test lassen sich die Modelle anhand einer angewandten Metriken (z. B. AUC, Gini, Brier-Score) auf signifikante Unterschiede zwischen den Algorithmen testen. Falls der Friedman-Test zeigt, dass Unterschiede existieren, sagt er aber nicht, welche Algorithmen signifikant unterschiedlich sind. Der Nemenyi-Test wird als Post-hoc-Test verwendet, um Paarvergleiche zwischen Algorithmen durchzuführen. Der Test zeigt, ob zwei Modelle sich signifikant unterscheiden.

Als Alternative zum Friedman-Test könnte auch ein ANOVA-Test durchgeführt werden. Hierfür sollten die Vergleichsdaten allerdings normal verteilt und unabhängig voneinander sein.

Die Integration von Large Language Models (LLMs) in den Validierungsprozess eröffnet innovative Möglichkeiten, um Ergebnisse zu analysieren, aufzubereiten und nutzbar zu machen. LLMs können helfen, komplexe Daten und Modelle zu interpretieren, valide Schlussfolgerungen zu ziehen und Berichte effizient zu erstellen. Besonders im Kontext der Multi-Model-Governance ermöglicht der Einsatz von LLMs eine systematische und nachvollziehbare Zusammenfassung von Erkenntnissen aus Metavergleichen und Validierungsprozessen.

Durch Automatisierung, verbesserte Kommunikation und interaktive Analysen können LLMs die Effizienz und Qualität von Validierungsberichten signifikant steigern. Erweiterungen wie Dashboards, regulatorisch-konforme Berichte und narrative Evaluierungen machen die Integration von LLMs zu einem zukunftsweisenden Ansatz im Bankenumfeld.

Einsatzmöglichkeiten von LLMs im Validierungsbericht:

Automatisierte Berichterstellung: LLMs können die Ergebnisse aus der Validierung (z. B. Performance-Vergleiche, Drift-Monitoring, SHAP-Analysen) in verständliche Berichte umwandeln.

Erklärung und Visualisierung: LLMs können komplexe Modellentscheidungen und Abweichungen in natürlicher Sprache erklären.

Anomalieerkennung und -bewertung: LLMs können Auffälligkeiten in den Daten oder Ergebnissen identifizieren und vorschlagen, wie diese zu interpretieren oder zu beheben sind.

Szenarioanalysen und Handlungsempfehlungen: LLMs können die Ergebnisse von Szenarioanalysen (z.B. unter Stressbedingungen) bewerten und konkrete Empfehlungen ableiten.

Übersicht über Multi-Model-Governance: LLMs können aus den Ergebnissen der Multi-Model-Analyse (z.B. Ranking von Modellen, Bayes’sche Analysen, Stabilität) eine governance-konforme Dokumentation erstellen.

Interaktive Dashboards mit LLM-Integration: Kombination von LLMs mit interaktiven Dashboards, um Benutzer in die Lage zu versetzen, Szenarien und Ergebnisse dynamisch zu analysieren.

Regulatorisch-konforme Zusammenfassung: LLMs können Berichte so strukturieren, dass sie den Anforderungen von Aufsichtsbehörden (z. B. BaFin, ECB) entsprechen.

Stakeholder-Kommunikation: LLMs können Berichte für verschiedene Stakeholder anpassen, z. B. technische Details für Data Scientists und regulatorische Übersichten für Führungskräfte.

Narrative Evaluierung von Modellalternativen: LLMs können narrative Texte generieren, die komplexe Vergleiche (z. B. zwischen Produktiv- und Challenger-Modellen) verständlich darstellen.

Während klassische Validierungsansätze eine solide Grundlage bieten, stoßen sie zunehmend an ihre Grenzen, wenn es darum geht, KI-gestützte Risikomodelle einzubinden. Die Integration von KI-basierten Challenger-Modellen eröffnet völlig neue Potenziale zur Erweiterung und Optimierung bestehender Validierungsprozesse und macht diese effizienter, präziser und dynamischer.

✅ Erweiterte Mustererkennung

KI kann komplexe Zusammenhänge in den Daten identifizieren, die klassischen Modellen verborgen bleiben. Dies ermöglicht eine tiefere Analyse von Modellannahmen und trägt dazu bei, potenzielle Schwachstellen frühzeitig zu erkennen.

✅ Dynamisches Monitoring und Drift-Erkennung

KI-Modelle ermöglichen eine kontinuierliche Überwachung der Modellperformance in Echtzeit. Insbesondere bei schnell wechselnden Marktbedingungen kann KI helfen, Concept Drift oder Feature Drift frühzeitig zu identifizieren und Gegenmaßnahmen einzuleiten.

✅ Automatisierte Validierungsprozesse

Viele aufwendige Validierungsschritte, wie Sensitivitätsanalysen, Szenarioanalysen oder Dokumentationserstellung, können durch KI-gestützte Automatisierung erheblich beschleunigt und standardisiert werden. Dies steigert nicht nur die Effizienz, sondern reduziert auch menschliche Fehlerquellen.

✅ Intelligente Challenger-Ansätze

KI-basierte Challenger-Modelle gehen über die klassische Überprüfung hinaus und ermöglichen eine aktive Verbesserung bestehender Ansätze. Durch adaptive Lernmethoden können sie helfen, robustere und widerstandsfähigere Modelle zu entwickeln.

Ein KI-konformer Validierungsprozess erfordert jedoch neue methodische Rahmenwerke, um Regulatorik, Transparenz und Modellrisiken angemessen zu berücksichtigen. In einem nächsten Beitrag werden wir am Beispiel von Kreditscoring-Modellen zeigen, wie sich KI-Challenger-Modelle einsetzten lassen um damit stetige Verbesserungen am produktiven Modell vornehmen zu können.

Als spezialisierte Unternehmensberatung unterstützen wir Banken bei der regulatorisch konformen Implementierung von ML-Modellen – von der Strategieentwicklung bis zur nachhaltigen Integration in bestehende Prozesse.

Möchten Sie mehr über KI-gestützte Modellvalidierung erfahren? Kontaktieren Sie uns für eine unverbindliche Beratung!