Der klassische Modellvalidierungsprozess

Grundlagen, Grenzen und Perspektiven

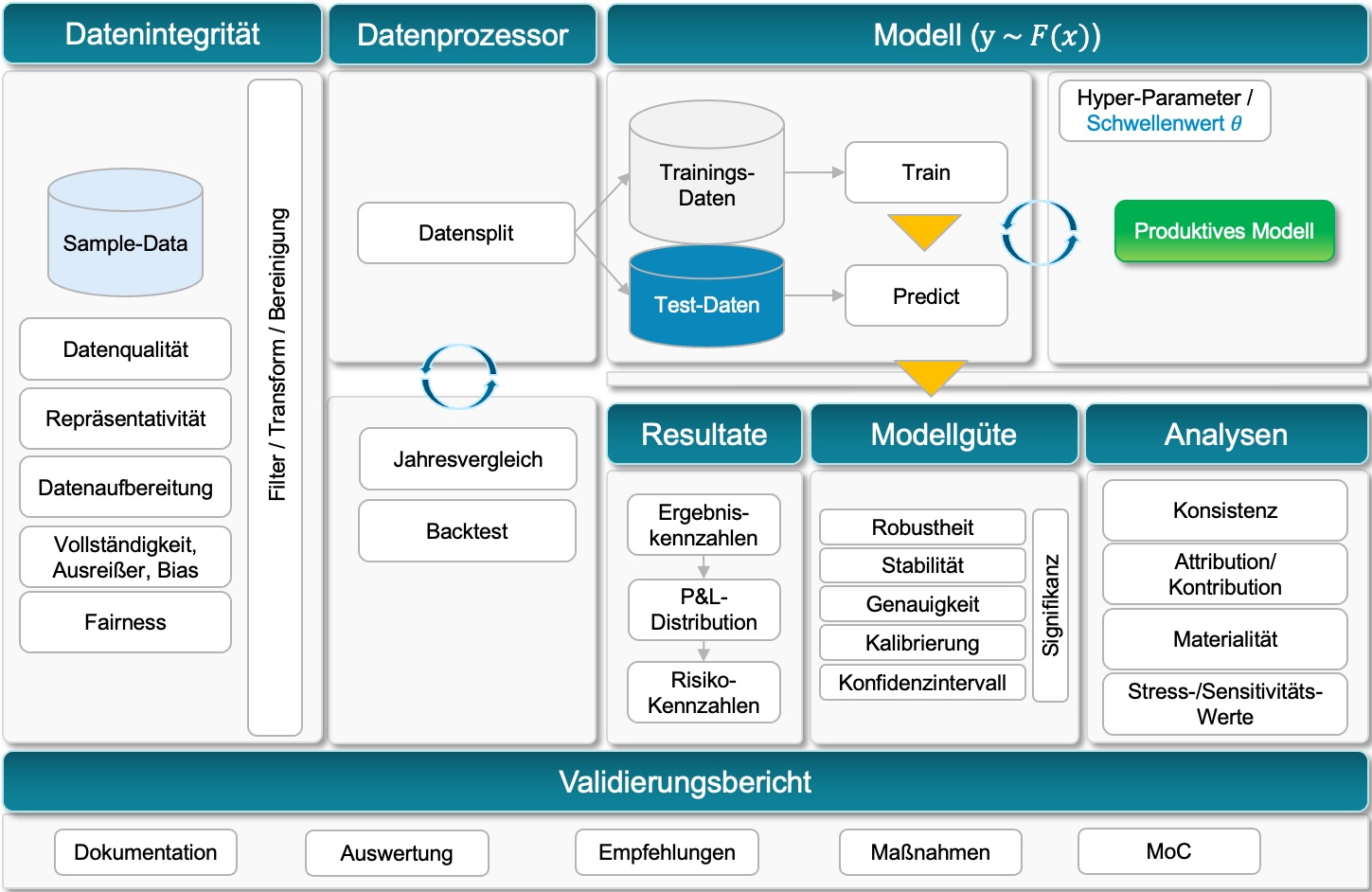

Die Validierung von Risikomodellen ist ein zentraler Bestandteil des Risikomanagements in Banken und wird durch strenge regulatorische Anforderungen bestimmt. Dennoch gibt es keinen einheitlichen Standard, da die Ansätze je nach internen Prozessen, technischen Möglichkeiten und Modellspezifika variieren.

Zunächst wird ein Überblick über den klassischen Validierungsprozess gegeben. Traditionelle Validierungsverfahren stoßen in einer zunehmend datengetriebenen und dynamischen Welt an ihre Grenzen – sei es durch die wachsende Komplexität moderner Modelle, die steigenden Anforderungen an Transparenz oder den Bedarf an effizienter Automatisierung.

Darauf aufbauend wird ein Ausblick für weiterführende Diskussionen über moderne Validierungsansätze angestoßen, darunter Automatisierungslösungen und der Einsatz von KI-Challenger-Modellen, die neue Potenziale in der Modellprüfung eröffnen. Im ersten Schritt liegt der Fokus jedoch auf dem klassischen Validierungsprozess, der als Ausgangspunkt für die Weiterentwicklung von Methoden und Technologien dient.

Schritte im Validierungsprozess

Der erste Schritt im klassischen Validierungsprozess ist die Sicherstellung der Datenintegrität, die eine zentrale Grundlage für valide Modellvorhersagen darstellt. Dabei stehen folgende Aspekte im Fokus:

Datenqualität: Die Daten werden auf Genauigkeit, Konsistenz und Verlässlichkeit überprüft, um sicherzustellen, dass sie für die Modellierung geeignet sind.

Repräsentativität: Es wird analysiert, ob die Daten die Zielpopulation oder den Zielprozess ausreichend abbilden.

Vollständigkeit: Fehlende Werte werden identifiziert und – falls möglich – durch geeignete Techniken wie Imputation ergänzt.

Ausreißer: Potenzielle Ausreißer, die die Modellgüte beeinträchtigen könnten, werden erkannt und entsprechend behandelt.

Bias und Fairness: Die Daten werden auf Verzerrungen (Bias) überprüft, um diskriminierende Muster zu vermeiden. Fairness-Analysen ergänzen diesen Schritt, insbesondere bei Modellen mit potenziell kritischen Entscheidungen.

Für die Verwendung der Daten werden diese in einem strukturierten Prozess weiter aufbereitet:

Filtern: Relevante Datensätze werden identifiziert und extrahiert.

Transformieren: Die Daten werden in ein Format gebracht, das die Modellanforderungen erfüllt (z. B. Normalisierung oder Encoding).

Bereinigen: Fehlerhafte oder redundante Daten werden entfernt, um die Modellstabilität zu gewährleisten.

Im zweiten Schritt des Validierungsprozesses werden die Eingangsdaten durch den Datenprozessor für die Modellbewertung aufbereitet. Ziel ist es, die Daten sinnvoll in Trainings- und Testdaten zu unterteilen, um eine objektive Bewertung der Modellgüte zu ermöglichen. Dabei kommen in der klassischen Validierung häufig spezifische Ansätze wie Backtests oder Jahresvergleiche zum Einsatz.

Dieser Zwischenschritt bildet die Grundlage für eine aussagekräftige und transparente Bewertung des Modells und stellt sicher, dass die Ergebnisse der Validierung belastbar und praxisnah sind.

Aufteilung in Trainings- und Testdaten:

Die Eingangsdaten werden in zwei (oder mehr) Datensätze aufgeteilt:

- Trainingsdaten: Diese werden verwendet, um das Modell zu trainieren und seine Parameter zu kalibrieren

- Testdaten: Diese bleiben unberührt, um eine unabhängige Überprüfung der Modellgüte zu gewährleisten.

Dabei wird darauf geachtet, dass die Verteilung der Daten (z. B. Klassenverhältnisse) in beiden Datensätzen repräsentativ bleibt.

Backtests:

Hierbei wird das Modell auf historischen Daten getestet, um zu prüfen, wie gut es vergangene Ereignisse korrekt vorhergesagt hätte. Dies bietet Einblicke in die Stabilität und Genauigkeit des Modells unter realistischen Bedingungen.

Jahresvergleiche:

Besonders bei Zeitreihenmodellen oder in Szenarien mit sich verändernden Daten wird überprüft, ob das Modell die Vorhersagekraft über mehrere Zeiträume hinweg aufrechterhält.

Nachdem die Daten im Datenprozessor aufbereitet und in Trainings- sowie Testdaten unterteilt wurden, erfolgt das Modelltraining und die anschließende Testphase, um die Leistungsfähigkeit des Modells zu bewerten. Dieser Schritt ist entscheidend, um sicherzustellen, dass das Modell sowohl robust als auch für den praktischen Einsatz geeignet ist.

Training des Modells (Train):

Mit Hilfe der Trainingsdaten wird das Modell so trainiert, dass es Muster in den Daten erkennt und Vorhersagen treffen kann. Ziel ist es, die Modellparameter so zu optimieren, dass die Vorhersagen sowohl akkurat als auch stabil bleiben.

Steuerung über Hyperparameter:

Hyperparameter, wie zum Beispiel Schwellenwerte (Theta), werden eingestellt, um die Leistung des Modells an die spezifischen Anforderungen anzupassen. Schwellenwerte können genutzt werden, um die Sensitivität des Modells zu steuern (z. B. welche Vorhersagen als Risiko klassifiziert werden). Der Auswahlprozess der Hyperparameter erfolgt oft durch Techniken wie Grid Search oder Random Search, um die optimale Kombination zu finden.

Testphase mit Forecasts (Predict):

Nach dem Training wird das Modell mit den Testdaten überprüft, die im Training nicht verwendet wurden. Ziel ist es, realistische Forecasts (Predict) zu generieren, die die Praxistauglichkeit und Robustheit des Modells bewerten.

Ergebnisbewertung und Auswertung

Ergebniskennzahlen:

Die Resultate des Modells werden anhand von spezifischen Kennzahlen bewertet. Dazu gehören beispielsweise Score-Werte, Ausfallwahrscheinlichkeiten oder erwartete Verluste

P&L-Verteilung und abgeleitete Risikokennzahlen:

Neben klassischen Modellkennzahlen wird häufig auch die P&L-Verteilung (Profit and Loss) analysiert. Von dieser werden in der Regel die Risikokennzahlen wie etwa der Value-at-Risk (VaR) abgeleitet. Diese zeigt, wie das Modell Entscheidungen im Hinblick auf finanzielle Gewinne und Verluste als auch auf das Risikomangagement beeinflusst und gibt Einblicke in die wirtschaftliche Robustheit des Modells. Eine detaillierte Analyse der P&L-Verteilung und den damit einhergehenden Quantil-Informationen ermöglicht es, Schwachstellen zu identifizieren, die die Stabilität oder Wirtschaftlichkeit des Modells beeinträchtigen könnten.

Im Validierungsprozess erfolgt nach dem Training und der initialen Testphase eine detaillierte Prüfung der Modellgüte, um sicherzustellen, dass das Modell nicht nur akkurat, sondern auch robust und stabil ist. Die Ergebnisse des Tests legen die Grundlage für die Entscheidung, ob ein Modell in den produktiven Betrieb überführt werden kann oder weiter optimiert werden muss. Dieser Schritt wird im Diagramm als „Modellgüte“ bezeichnet und ist entscheidend, um die Zuverlässigkeit und Leistungsfähigkeit des Modells zu bewerten.

Bewertung der Modellgüte:

Modellgüte ist ein Sammelbegriff, der die Gesamtqualität eines Modells beschreibt. Sie bewertet, wie gut ein Modell seine Aufgabe erfüllt und welche Vorhersagekraft es besitzt. Dabei berücksichtigt die Modellgüte verschiedene Dimensionen:

Robustheit: Robustheit beschreibt die Fähigkeit eines Modells, auch unter unsicheren oder veränderten Bedingungen korrekte Vorhersagen zu treffen. Es geht darum, wie gut das Modell auf abweichende oder fehlerhafte Eingabedaten oder unvorhergesehene Szenarien reagiert.

Stabilität: Stabilität beschreibt die Fähigkeit eines Modells, über Zeit hinweg und bei wiederholten Anwendungen konsistente Ergebnisse zu liefern. Es geht um die Zuverlässigkeit der Vorhersagen bei gleichbleibenden Bedingungen, also darum, wie empfindlich das Modell auf kleine Änderungen der Eingangsdaten oder des Modellaufbaus reagiert.

Genauigkeit: Die Genauigkeit eines Modells gibt an, wie viele Vorhersagen (z. B. Ausfall oder Nicht-Ausfall) korrekt sind, gemessen am Anteil der richtig klassifizierten Ereignisse an der Gesamtanzahl der Vorhersagen.

Kalibrierung: Kalibrierung bewertet, wie gut die vorhergesagten Wahrscheinlichkeiten mit den tatsächlichen Ereignissen übereinstimmen. Sie ist besonders wichtig für die praktische Anwendung probabilistischer Modelle.

Konfidenzintervall: Konfidenzintervalle quantifizieren die Unsicherheit in den Vorhersagen oder Parametern eines Modells. Sie geben den Bereich an, in dem die tatsächlichen Werte mit einer bestimmten Wahrscheinlichkeit liegen.

Prüfung auf Signifikanz:

Der Begriff Signifikanz ist ein statistisches Konzept und in der Modellvalidierung vor allem relevant, wenn es darum geht, die Zuverlässigkeit von Ergebnissen und Schätzungen zu beurteilen. Signifikanz misst, ob ein beobachteter Effekt oder eine Beziehung in den Daten wahrscheinlich nicht durch Zufall zustande gekommen ist. Sie ist insbesondere wichtig bei der Bewertung von Modellen, Parametern und Hypothesen. Signifikanz spielt eine spezifische Rolle in der Validierung und grenzt sich klar von den anderen Begriffen wie Genauigkeit, Kalibrierung oder Robustheit ab. Sie ergänzt diese Begriffe, indem sie die statistische Verlässlichkeit von Modellaussagen bzw. -eigenschaften bewertet. Typische Tests (z.B. der Kolmogorov-Smirnof-Test) umfassen p-Werte oder Hypothesentests zur Validierung der Modellparameter.

Nach der Prüfung der Modellgüte folgt ein detaillierter Analyseblock, in dem die Belastbarkeit und Konsistenz des Modells umfassend überprüft werden. Im Gegensatz zu den Modellgüte-Tests, die sich auf die Leistungsfähigkeit und grundlegende Qualität eines Modells konzentrieren, dienen Analysen in der Regel dazu, tiefergehende Einsichten in die Funktionsweise, die strukturelle Validität und die praktischen Auswirkungen eines Modells zu gewinnen. Sie ergänzen die Bewertung der Modellgüte auf einer feineren Ebene. Ziel ist es, nicht nur die Qualität der Modellvorhersagen weiter zu bewerten, sondern auch die zugrunde liegenden Annahmen und Beiträge einzelner Variablen transparent darzustellen.

Konsistenzchecks:

Ziel von Konsistenzchecks ist die Überprüfung, ob das Modell bei gleichen oder ähnlichen Bedingungen konsistente Ergebnisse liefert. Konsistenzchecks sind eng mit der Stabilität eines Modells verknüpft, die bereits bei der Modellgüte getestet wurde. Jedoch sind Konsistenzchecks detaillierter und zielen darauf ab, spezifische Inkonsistenzen in den Ergebnissen oder in den zugrunde liegenden Prozessen (z. B. Datenaufbereitung) aufzudecken.

Materialitäts-Einschätzungen:

Materialitäts-Einschätzugen dienen der Bewertung, wie stark einzelne Modellkomponenten oder Variablen die Ergebnisse beeinflussen. Im Gegensatz zu allgemeinen Modellgüte-Tests, die die Gesamtleistung messen, konzentrieren sich Materialitäts-Einschätzungen auf die Relevanz einzelner Komponenten. Sie helfen zu verstehen, welche Parameter oder Variablen entscheidend für die Modellvorhersagen sind, und ermöglichen es, weniger signifikante Faktoren zu identifizieren oder zu eliminieren.

Attributions- und Kontributionsanalysen:

Dies Analysen erlauben die Identifikation und Quantifizierung des Einflusses einzelner Variablen (Attribution) oder Gruppen von Variablen (Kontribution) auf die Modellvorhersagen. Sie gehen über die Modellgüte hinaus, indem sie die Funktionslogik des Modells transparent machen. So liefern sie Einblicke, wie Variablen miteinander interagieren und ob ihre Einflüsse konsistent mit den Modellannahmen sind. Während Attributionsanalysen spezifische Variablen bewerten, betrachten Kontributionsanalysen größere Gruppen oder Kategorien, was sie besonders bei komplexen Modellen relevant macht.

Stress- und Sensitivitätstests:

Die Bewertung der Robustheit eines Modells durch Simulation extremer Szenarien (Stress) oder durch gezielte Variation einzelner Eingabefaktoren (Sensitivität) zielen auf die Belastbarkeit eines Modells ab und ergänzen die Robustheitstests aus den Modellgüte-Tests. Sie fokussieren sich jedoch stärker auf praktische Szenarien und regulatorische Anforderungen, indem sie untersuchen, wie das Modell auf seltene oder extreme Bedingungen reagiert.

Der letzte Schritt im Validierungsprozess ist die Erstellung des Validierungsberichts, der die Ergebnisse der gesamten Prüfung zusammenfasst und dokumentiert. Dieser Schritt dient nicht nur der internen Transparenz, sondern ist auch eine zentrale Grundlage für die Kommunikation mit Regulierungsbehörden und anderen Stakeholdern.

Dokumentation:

Sämtliche durchgeführten Tests, Analysen und Methoden werden ausführlich dokumentiert, einschließlich der verwendeten Daten, Modelle und Parameter. Die Dokumentation ist entscheidend, um die Nachvollziehbarkeit des Validierungsprozesses sicherzustellen und regulatorischen Anforderungen gerecht zu werden.

Auswertung der Ergebnisse:

Alle Erkenntnisse aus den vorherigen Prozessschritten werden systematisch zusammengetragen. Die Auswertung umfasst quantitative Ergebnisse (z. B. Modellgüte, Kalibrierung, Robustheit) sowie qualitative Analysen (z. B. Attributions- und Sensitivitätsanalysen). Besondere Aufmerksamkeit gilt der Identifikation von Schwächen oder Risiken, die während der Validierung aufgedeckt wurden.

Empfehlungen und Maßnahmen:

Basierend auf den Ergebnissen gibt der Bericht klare Empfehlungen für Verbesserungen oder Anpassungen des Modells. Diese können beispielsweise die Anpassung von Hyperparametern, die Erweiterung des Datensatzes oder die Durchführung zusätzlicher Tests umfassen. Bei gravierenden Schwächen werden konkrete Maßnahmenpläne erstellt, um diese Schwächen zu beheben.

Margin of Conservatism (MoC):

Die MoC bezeichnet einen Sicherheitszuschlag oder eine konservative Anpassung, die in Risikomodellen angewendet wird, um Unsicherheiten und Schwächen in der Modellierung zu kompensieren. Die MoC wird angewendet, um das inhärente Modellrisiko zu adressieren, das aus Unsicherheiten bei Annahmen, Daten oder Methodologien resultiert. Sie sorgt dafür, dass die Risikobewertungen konservativ genug sind, um eine Unterschätzung des tatsächlichen Risikos zu vermeiden. Ziel ist es, sicherzustellen, dass Banken auch unter realen und stressigen Marktbedingungen genügend Kapital halten, um Verluste abzudecken.

Die klassische Validierung repräsentiert eine solide Grundlage für die Modellprüfung. Sie legt die Basis für ein robustes Risikomanagement und stellt sicher, dass regulatorische Anforderungen erfüllt werden. Doch mit der Weiterentwicklung von KI und Machine-Learning-Technologien eröffnen sich neue Möglichkeiten, die klassischen Verfahren zu ergänzen und deren Grenzen zu überwinden.

Der klassische Validierungsansatz hat sich über die Jahre bewährt und erfüllt die grundlegenden Anforderungen an die Modellbewertung in Banken. Dennoch stößt dieser Ansatz zunehmend an seine Grenzen, insbesondere in einer komplexeren, datenintensiven und dynamischen Welt. Die typischen Herausforderungen lassen sich wie folgt zusammenfassen:

- Begrenzte Flexibilität bei komplexen Modellen:

Klassische Ansätze basieren häufig auf linearen oder statistischen Modellen, die die hochdimensionalen und nichtlinearen Beziehungen in modernen Daten oft nur unzureichend abbilden können. Modelle wie Monte-Carlo-Simulationen werden gelegentlich als Challenger-Ansatz genutzt, bieten aber nur eine begrenzte Abdeckung von Variabilität und Unsicherheit. - Hoher manueller Aufwand:

Die Datenaufbereitung (Datenintegrität), Prüfungen und Dokumentationen sind häufig zeit- und ressourcenintensiv. Besonders bei großen und heterogenen Datensätzen erfordert dies erhebliche Kapazitäten und verlängert die Validierungszyklen. - Einschränkungen bei der Ergebnisanalyse:

Die klassischen Methoden liefern zwar klare Ergebniskennzahlen, wie Diskriminierungskraft oder Kalibrierung, stoßen aber an ihre Grenzen, wenn es darum geht, komplexe Interaktionen zwischen Variablen oder potenzielle Schwächen im Modellverhalten aufzudecken. - Statische Prüfprozesse:

Klassische Validierungen erfolgen oft in festgelegten Zyklen (z. B. jährliche Validierung), was es schwierig macht, auf dynamische Änderungen in den Daten oder den zugrunde liegenden Bedingungen zeitnah zu reagieren. - Mangelnde Automatisierung:

Die fehlende Automatisierung in vielen Schritten, wie der Attributions- oder Sensitivitätsanalyse, erschwert eine effiziente Modellbewertung und reduziert die Möglichkeiten für ein kontinuierliches Monitoring. - Limitierter Einsatz klassischer Challenger-Modelle:

Während gelegentlich Challenger-Modelle wie Monte-Carlo-Simulationen oder einfache Szenariotests genutzt werden, fehlt diesen oft die Fähigkeit, tiefere Muster und nichtlineare Beziehungen in den Daten zu erkennen. Ihre Funktion beschränkt sich in der Regel auf die Bestätigung oder Widerlegung einzelner Modellannahmen.

Die klassischen Validierungsansätze bieten zwar eine solide Grundlage, können jedoch mit den Anforderungen an moderne Risikomodelle oft nicht Schritt halten. Hier eröffnen KI-gestützte Challenger-Modelle völlig neue Potenziale, um die bestehenden Validierungsprozesse zu erweitern und zu optimieren:

Erweiterte Mustererkennung: KI kann tiefergehende Zusammenhänge in den Daten erkennen, die klassischen Modellen verborgen bleiben, und somit neue Perspektiven auf Modellannahmen und -ergebnisse liefern.

Automatisiertes Monitoring: KI ermöglicht eine kontinuierliche Überwachung und Bewertung von Modellen in Echtzeit, was vor allem bei schnell wechselnden Marktbedingungen entscheidend ist.

Höhere Effizienz: Durch den Einsatz von KI können zeitaufwendige Schritte, wie Sensitivitätsanalysen oder Dokumentationen, teilweise oder vollständig automatisiert werden.

Umfassendere Challenger-Ansätze: KI-basierte Challenger-Modelle erweitern die Möglichkeiten, bestehende Ansätze nicht nur zu überprüfen, sondern aktiv zu verbessern.

In einem nächsten Beitrag werden wir detailliert beschreiben, wie KI-Challenger-Modelle klassische Validierungsprozesse ergänzen können, welche Voraussetzungen für ihren erfolgreichen Einsatz erfüllt sein müssen und welche regulatorischen Aspekte dabei zu berücksichtigen sind.

Als spezialisierte Unternehmensberatung unterstützen wir Banken bei der regulatorisch konformen Implementierung von ML-Modellen – von der Strategieentwicklung bis zur nachhaltigen Integration in bestehende Prozesse.

Möchten Sie mehr über KI-gestützte Modellvalidierung erfahren? Kontaktieren Sie uns für eine unverbindliche Beratung!